KW预训练模型

金融领域预训练大模型FinT5

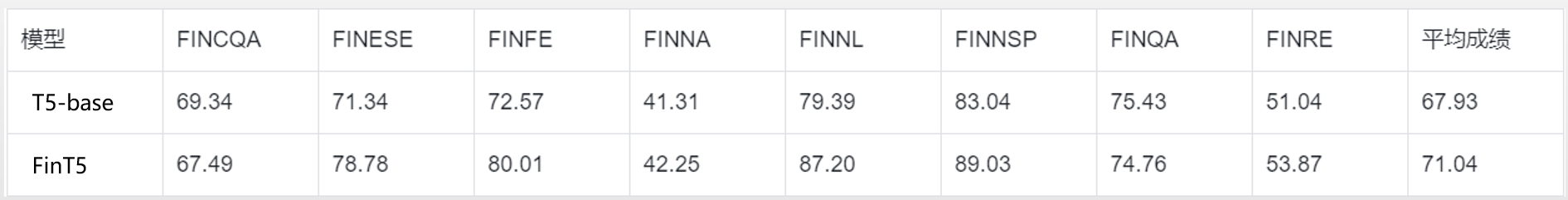

首个大规模中文金融预训练语言模型,在涵盖公告,研报,论坛等多种来源的数百GB语料上进行训练,结合创新性的来源提示算法,在8个下游任务上超过Google T5 3%以上。

使用方法

下载并解压模型参数,并使用以下代码载入。

from transformers import AutoTokenizer, T5ForConditionalGeneration

tokenizer = AutoTokenizer.from_pretrained("./path/to/FinMT5_base")

model = T5ForConditionalGeneration.from_pretrained("./path/to/FinMT5_base")

对比效果

下游任务试用:金融新闻文本分类

将金融类新闻分类为公司(个股), 行业(板块), 大盘, 中国, 国际, 经济, 政策, 期货, 债券, 房地产, 外汇, 虚拟货币, 新冠, 能源,添加前缀中国或外国。

{{inpr_finnl}}

{{ret_finnl}}

下游任务试用:金融新闻自动摘要

自动对金融类新闻进行摘要。

{{inpr_finna}}

{{ret_finna}}

下载地址

点击下载模型参数 此版本仅供学术研究使用,具有更好效果的商用Large版本模型请联系我们。KW中英文混合Roberta

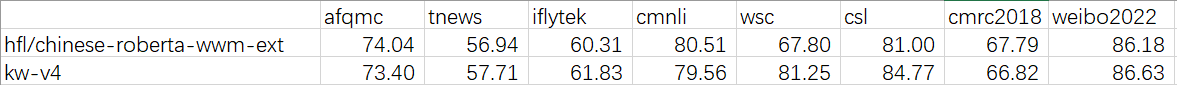

对目前中文Bert/Roberta的Tokenizer进行了更新,使其更符合中文任务,并在数百GB语料上训练,在CLUE分类任务上达到较好效果,部分任务有巨大提升。

- 和HuggingFace BertTokenizer兼容,Fast版本速度和原版相当。

- 所有中文字符和数字进行了切分,2077->2/0/2/2, 原版分词器分为207/7。

- 保留了空格使切分的Token序列和原文本对齐,并将空格全部替换为特殊符号□。(注意,某些下游任务的匹配过程中需要注意空格和□的匹配。)

- 增加了中文文本中常见,但在原分词器中为[UNK]的符号,如省略号…

- (最重要)基于此分词器,在数百GB中文语料和部分英文语料上进行WWM训练,在CLUE测试上获得较好效果。

使用方法

下载并解压模型参数,并使用以下代码载入。

from cetokenizer import CEBertTokenizer, CEBertTokenizerFast

from transformers import BertTokenizer, BertModel, BertConfig

tokenizer = CEBertTokenizerFast('vocab.txt')

config = BertConfig.from_pretrained('hfl/chinese-roberta-wwm-ext')

config.vocab_size = len(tokenizer.vocab)

model = BertModel(config)

model.load_state_dict(torch.load('kw_roberta_ce_v4.pt'), strict=False)

对比效果